Att förstå RAG i kontexten av Azure AI

RAG är utformat för att göra generativ AI mer förankrad och tillförlitlig. Medan de flesta stora språkmodeller genererar svar enbart baserat på sin träningsdata, introducerar RAG en mekanism som hämtar relevant innehåll från betrodda datakällor innan svaret genereras. Detta säkerställer att resultatet inte bara är kontextuellt relevant, utan också faktamässigt korrekt.

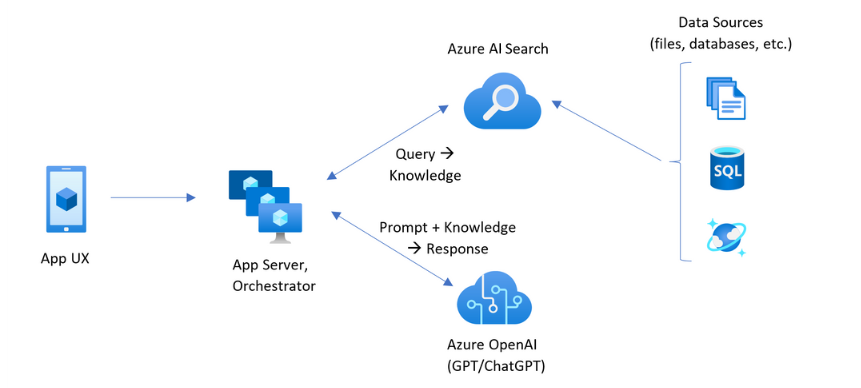

I Azure AI Foundry fungerar RAG som en pipeline där information flödar dynamiskt mellan retrievern och generatorn.

Arkitekturen bygger på tre konceptuella steg: indexering, retrieval och generering. I indexeringsfasen lagras och struktureras företagsdata – såsom manualer, rapporter eller e-post – i Azure AI Search. Varje dokument delas upp i mindre segment och representeras genom vektorembeddingar med hjälp av Azure OpenAI Embeddings API.

När en användare skickar in en fråga påbörjas retrieval-fasen, där Azure AI Search identifierar de mest relevanta innehållssegmenten baserat på semantisk likhet. Dessa resultat bildar den kontext som vägleder generatorn, vanligtvis en Azure OpenAI-modell som GPT-5, när det slutliga svaret ska produceras. Denna design gör systemet både dynamiskt och verifierbart.

På Microsoft Ignite finns en graf som illustrerar hur RAG fungerar för att stödja AI-tjänster.

Hur det fungerar i praktiken i Azure AI Foundry

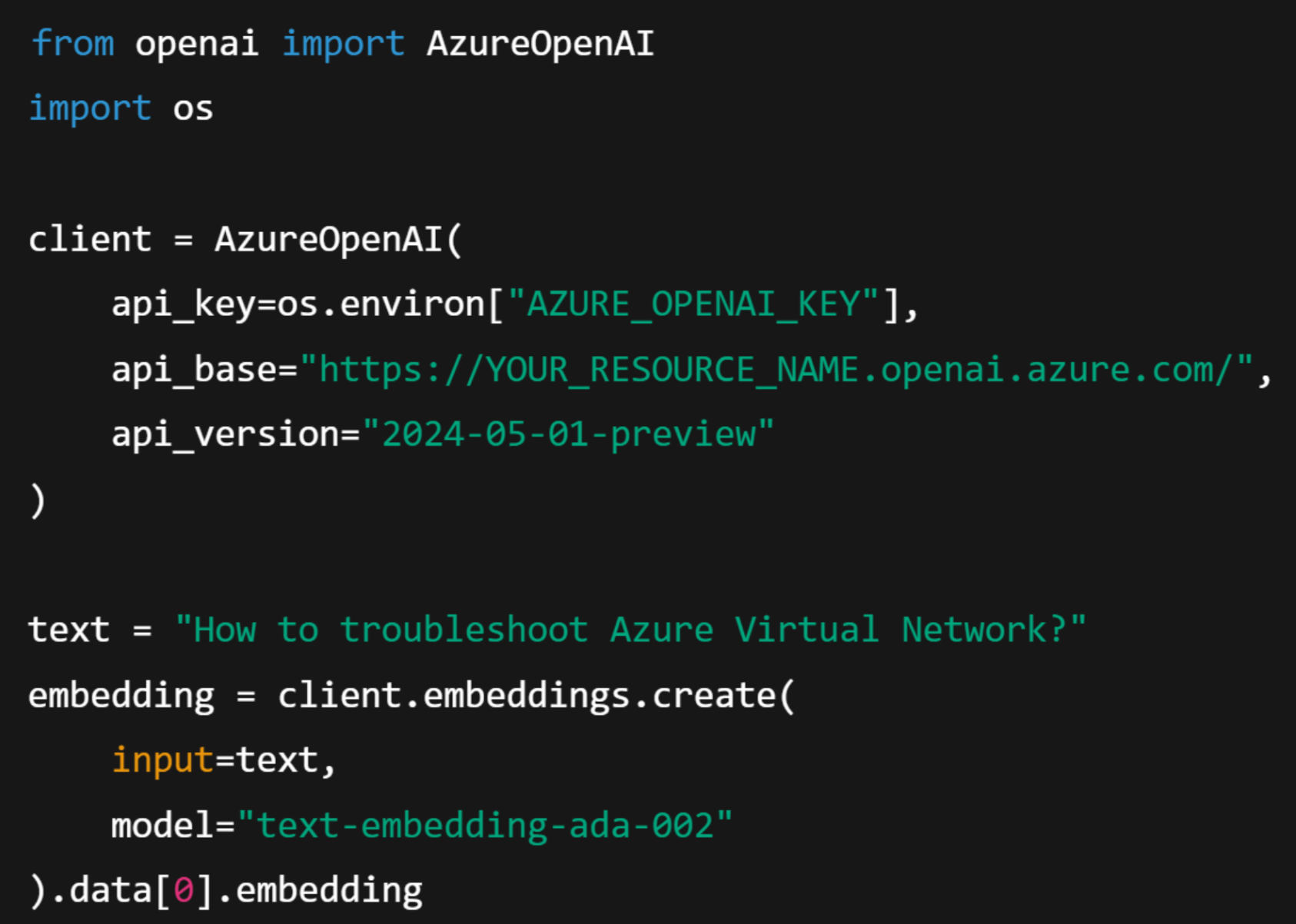

I Azure AI Foundry blir RAG-processen enklare att bygga och skala eftersom plattformen samlar vektorsökning, prompt-orkestrering och övervakning i ett enda hanterat arbetsutrymme. Databeredning är det första kritiska steget. Företagsfiler konverteras till textembeddingar med hjälp av Azure OpenAI-modeller, till exempel text-embedding-ada-002. Dessa embeddingar lagras sedan i Azure AI Search, som fungerar som retrieval-index.

När en fråga skickas in använder systemet embeddingarna för att genomföra en hybridsökning som kombinerar nyckelordsrelevans med semantisk likhet. Detta säkerställer att retrievern hittar de mest relevanta dokumenten även om användare formulerar sina frågor på olika sätt.

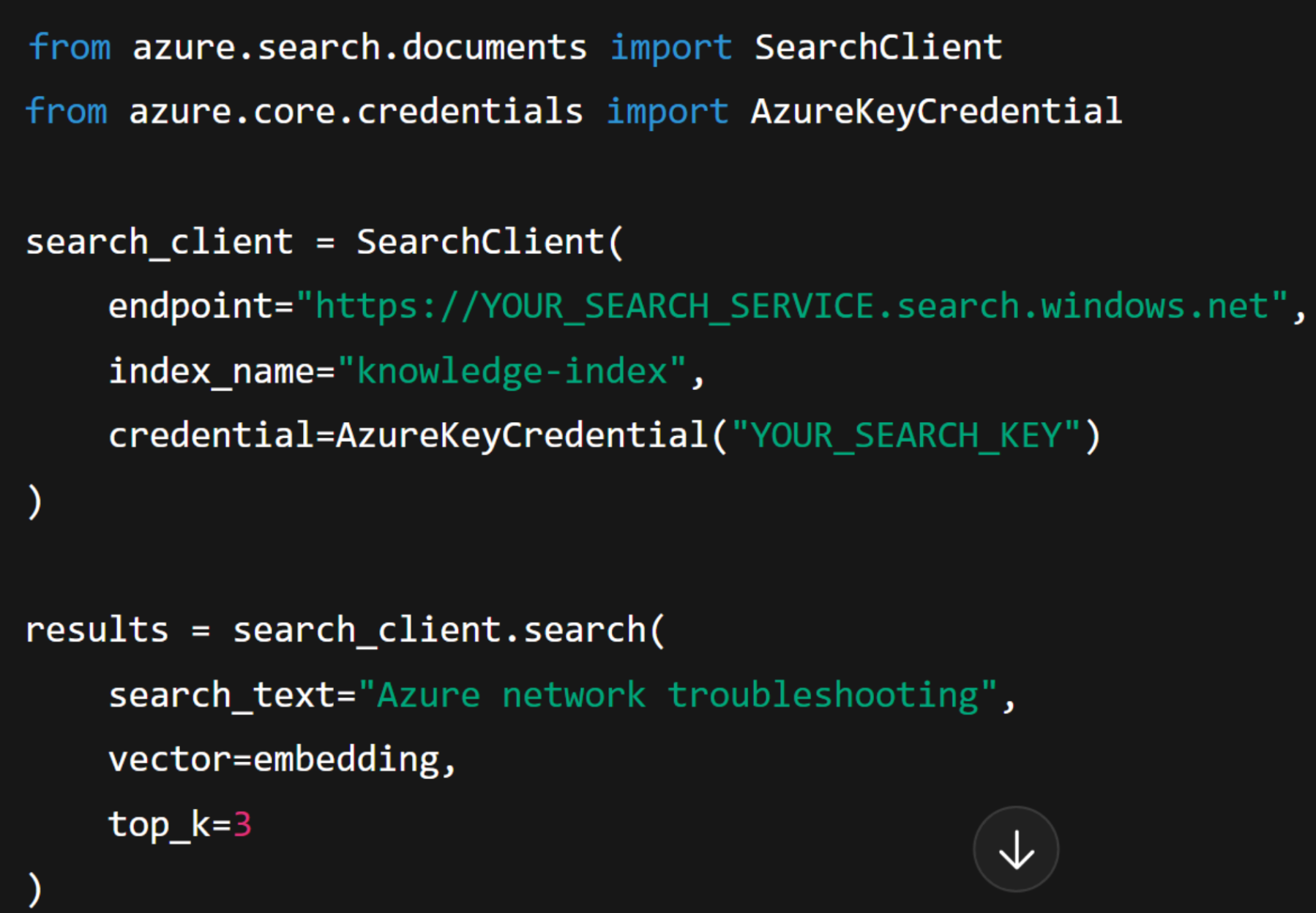

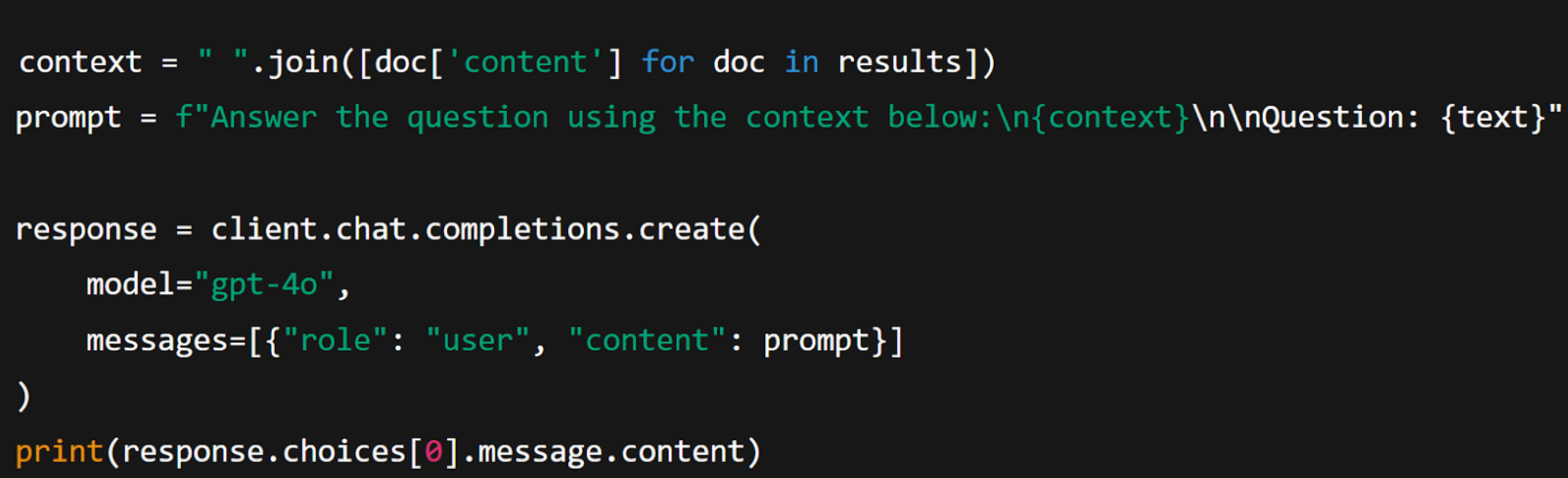

Efter att embeddingarna genererats görs själva retrieval-fasen där indexet frågas ut. I detta steg kombinerar Azure AI Search både vektor- och nyckelordssignaler för att leverera de mest relevanta resultaten, vilka därefter skickas vidare till prompten.

När den relevanta kontexten har hämtats går systemet vidare till genereringssteget. Den hämtade texten sammanfogas till en enda kontextprompt som vägleder modellen i att formulera ett korrekt och kontextmedvetet svar.

Slutligen erbjuder Azure AI Foundry observability-verktyg som Prompt Flow, Trace Studio och Model Monitoring. Dessa gör det möjligt för team att spåra varje förfrågan, validera retrieval-precision och utvärdera latens. Denna operativa transparens är avgörande för SMB:er som vill gå från experimentering till stabila, produktionsklara lösningar.

Varför RAG är viktigt för SMB:er

För små och medelstora organisationer är en av de största utmaningarna i AI-implementering att upprätthålla tillit och faktamässig korrekthet. Traditionella modeller som tränats på generiska dataset producerar ofta trovärdiga men felaktiga svar. RAG löser detta genom att förankra varje svar i verifierad företagsdata. Det säkerställer att AI-genererad kunskap speglar organisationens faktiska policyer, produkter och processer.

I praktiken möjliggör RAG nya nivåer av effektivitet i olika delar av organisationen.

- Kundsupport kan automatisera svar som baseras på officiella manualer istället för generisk modellkunskap.

- Kunskapshantering kan göra det möjligt för medarbetare att söka i interna dokument med naturligt språk i exempelvis SharePoint eller Teams.

- Compliance-funktioner kan snabbt hitta hänvisningar till regulatoriska klausuler i omfattande kontrakt.

- Säljteam kan generera aktuella produktinsikter direkt från godkänt innehåll.

Alla dessa användningsfall visar hur RAG förenar generativ AI-förmåga med tillförlitlig datastyrning på Azure.

Best Practices för att bygga tillförlitliga RAG-system

Vid implementering av RAG i produktion är uppmärksamhet på dataaktualitet avgörande. Organisationer bör regelbundet re-indexera sin data för att säkerställa att nya dokument och policyuppdateringar finns med i sökresultaten. Det är också viktigt att optimera storleken på textsegmenten.

Övervakning av kvalitet är ytterligare ett kritiskt steg. Azure AI Foundrys utvärderingsverktyg gör det möjligt att mäta hur väl modellens svar överensstämmer med den hämtade faktan, bland annat genom metrik som Faithfulness. Dessa insikter hjälper team att justera chunking-strategier, retrieval-trösklar eller prompt-design. Slutligen bör ansvarsfull AI-användning vara en självklarhet. Azure AI Content Safety erbjuder skydd för att filtrera känsligt eller olämpligt innehåll och hjälper organisationer att upprätthålla efterlevnad och användarförtroende.

Vanliga utmaningar vid RAG-implementering

Team som är nya inom RAG gör ofta liknande misstag som begränsar skalbarhet eller noggrannhet. Ett vanligt problem är att inte hantera versionskontroll av embeddingar, vilket leder till inkonsekventa resultat när embeddingar uppdateras. Ett annat är att mata in för många dokument i prompten, vilket ökar kostnader och försämrar fokuset i genereringen. Prestandaproblem kan också uppstå när embeddingar beräknas om i onödan istället för att cachelagras. Att adressera dessa utmaningar tidigt hjälper SMB:er att etablera en stabil grund innan RAG används för mer komplexa arbetsflöden.

Vi hjälper er att accelerera er AI-transformation

På Precio Fishbone hjälper vi organisationer att frigöra hela potentialen i Azure AI genom säkra, produktionsklara implementationer. Vår expertis omfattar AI-arkitekturdesign, dataintegration, modellstyrning och Copilot-anpassning, vilket gör att företag kan gå från experiment till mätbar effekt.

Oavsett om ni vill förbättra kunskapshantering, automatisera kundinteraktioner eller skala intelligenta beslutsstöd i organisationen kan vårt AI Solutions-team hjälpa er att bygga ansvarsfullt och leverera tryggt på Azure.

Kan man bygga RAG utan att använda Azure AI Search?

Det är tekniskt möjligt att använda andra databaser för informationshämtning, men Azure AI Search har inbyggd integration med Azure OpenAI, stöd för hybrid-sökning och säkerhet i företagsklass – vilket förenklar både utveckling och skalning.

Tar RAG helt bort hallucinationer?

Det minskar dem avsevärt genom att svaren baseras på faktagrundad information. Men inget generativt system är helt fritt från hallucinationer, så kontinuerlig övervakning och utvärdering är fortfarande viktigt.

Hur ofta bör en organisation reindexera sin data?

Dynamiskt innehåll, som supportartiklar eller produktdokumentation, mår bra av att indexeras varje vecka. Mer statisk information, som policys eller manualer, kan uppdateras månadsvis.